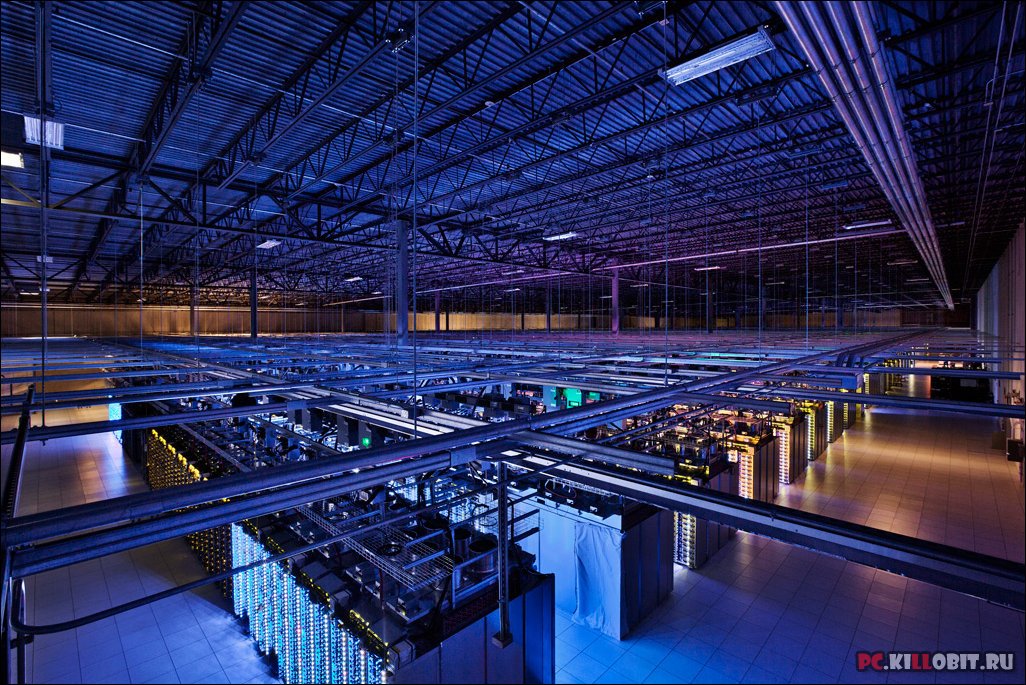

Google широко развивающаяся компания, которая имеет свои разработку не только в интернет области, но и в техническом плане, примером тому их ЦОДы где Google приложила руку. Суммарная мощность его 220 МВт и она растет с каждым днем, компания вкладывает большие инвестиции в ЦОДы, при этом Google имеет от 40 до 45 дата-центров по всему миру, хочу отметить сам Google не занимается строительством ЦОД, у него есть департамент, который занимается развитием и сопровождением, а компания сотрудничает с местными интеграторами, которые и выполняют внедрение. При строительстве ЦОДов и выборе места

строительства Google учитывает такие моменты как низкую стоимость электроэнергии, наиболее экологически чистое происхождения её, наличие большого количества воды для охлаждения серверов, надежные каналы связи (их должно быть несколько), площадь земли для расширения территории, налоговые льготы при использовании «зеленой технологии»

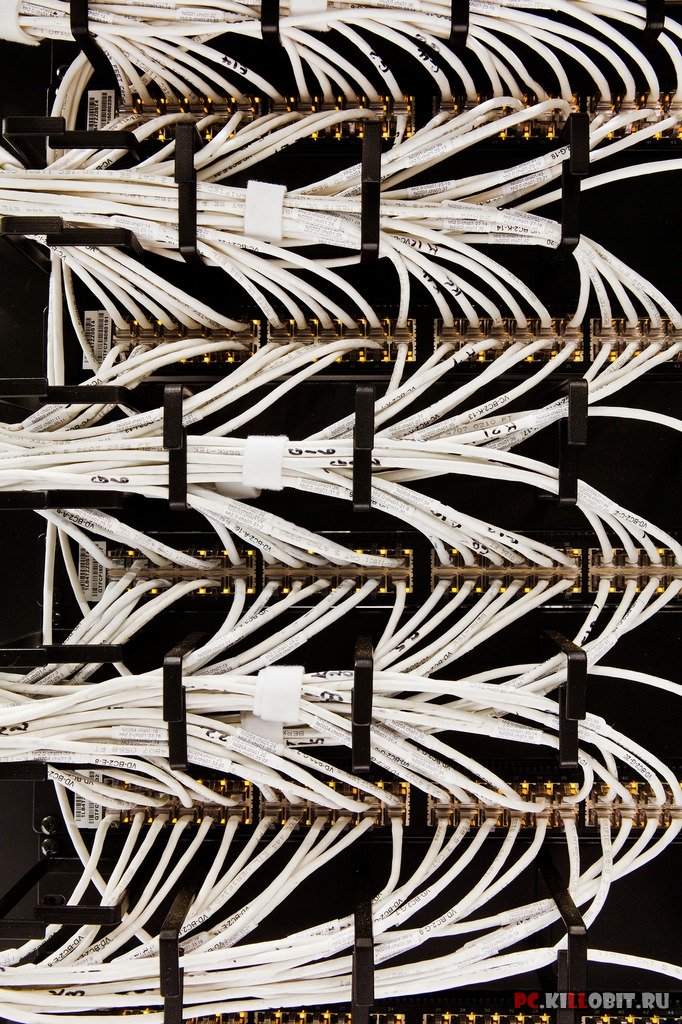

О количестве серверов Google не сообщает, но различные источники сообщают цифру в несколько миллионов, платформа серверов x86, а в качестве операционной системы используется модифицированная версия Linux, все серверы объединены в кластерное решение.

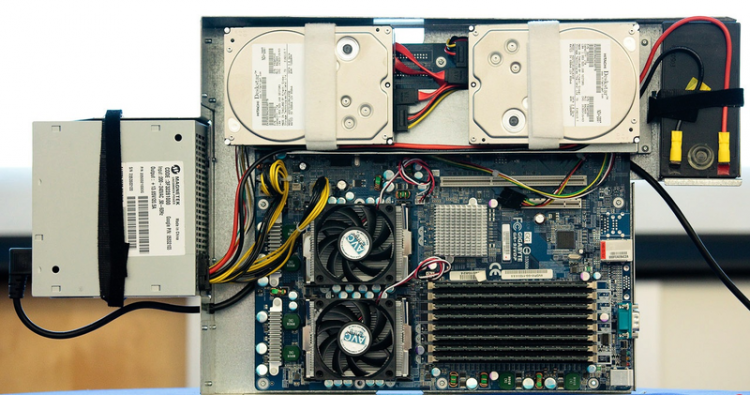

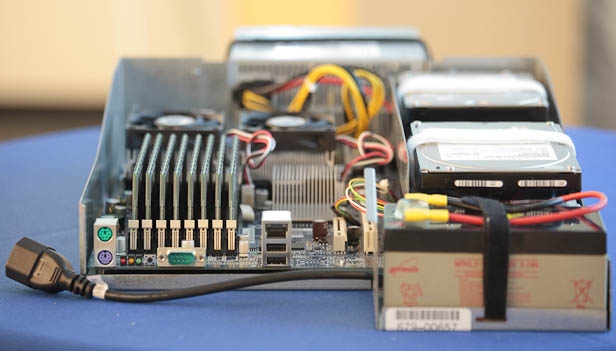

Компания еще в 2000 году задумалась над уменьшением потерь передачи и трансформации электроэнергии в серверах. Поэтому блоки питания соответствуют уровню Gold стандарта Energy Star — КПД блока питания не менее 90%. Также из серверов были убраны все компоненты, которые не требуются для выполнения приложений, работающих на них. К примеру, в серверах отсутствуют графические адаптеры, стоят вентиляторы с контролем оборотов, а компоненты позволяют пропорционально загрузке уменьшать свое энергопотребление. Интересно, что в больших дата-центрах и контейнерных ЦОД, где серверы являются по сути расходным материалом, видимо, было решено: срок жизни серверов сопоставим с жизнью аккумуляторов. А раз так, то вместо ИБП – батарея, которая устанавливается в корпус самого сервера. Так удалось уменьшить потери на ИБП и исключить проблему его низкого КПД при малой нагрузке. Известно, что использовалась двухпроцессорная платформа x86, а производством материнских плат специально для Google занималась небезызвестная компания Gigabyte. Любопытно, что сервер не имеет привычного нам закрытого корпуса: присутствует лишь нижняя его часть, где размещаются жесткие диски, материнская плата, батарея и блок питания (рис. ниже). Процесс установки очень прост: администратор вытягивает металлическую заглушку из монтажного поля и вставляет вместо нее сервер, который свободно продувается с фронтальной части на тыльную. После установки выполняется подключение батареи и блока питания.

Состояние и работоспособность каждого жесткого диска сервера отслеживается. Дополнительно выполняется архивация данных на ленточные носители. Своеобразно решена проблема утилизации нерабочих носителей информации — жестких дисков. На первом этапе диски по очереди попадают на некое подобие пресса: металлический наконечник продавливает жесткий диск, спрессовывает камеру с пластинами, чтобы сделать невозможным чтение с них любым имеющимся на данный момент способом. Затем диски попадают в шредер, где их измельчают, и только после этого они могут покинуть территорию дата-центра. Известно, что, кроме аппаратного обеспечения, Google использует файловую систему Google File System (GFS), предназначенную для больших массивов данных. Особенность этой системы в том, что она кластерная: информация делится на блоки по 64 Мбайт и хранится минимум в трех местах одновременно с возможностью находить реплицированные копии. Если какая-то из систем выйдет из строя, реплицированные копии находятся автоматически, с помощью специализированных программ модели MapReduce. Сама модель подразумевает распараллелирование операций и выполнение задач на нескольких машинах одновременно. При этом внутри системы информация шифруется. Система BigTable использует распределенные массивы хранения данных для сохранения большого массива информации с быстрым доступом для хранения, например, веб-индексации, Google Earth and Google Finance. В качестве базовых веб-приложений применяются Google Web Server (GWS) и Google Front-End (GFE), использующие оптимизированное ядро Apache. Все эти системы являются закрытыми и кастомизированными — Google объясняет это тем, что закрытые и кастомизированные системы очень устойчивы против внешних атак и в них значительно меньше уязвимостей. Подводя итоги, хотелось бы отметить несколько важных моментов, которые не могут не удивлять. Компания Google разумно планирует затраты и стратегию развития дата-центров, применяя понятие «лучшее по цене/качеству» вместо «наилучшее решение». Нет лишнего функционала, нет никаких декоративных излишеств — только «спартанское» наполнение, хотя кому-то это может показаться не эстетичным.

Ниже пачка красивых фото из Дата-Центра